AI漫画家

2022年8月に無償公開されたStable Diffusionについて、今回は解説していきたいと思います!!

使い方を覚えると、画像生成AIの中で一番汎用性が高く、いろいろなシーンを画像として出せるので、おすすめです!!

1. 【導入】Stable Diffusionとは?なぜ注目されているのか

2022年に登場した「Stable Diffusion(ステーブル・ディフュージョン)」は、テキストから高精細な画像を生成できるAIツールです。オープンソースとして無料公開されたことにより、世界中のクリエイターやエンジニアが日々改良を加え、進化を続けています。

たとえば「サイバーパンク風の夜景」や「浮世絵風の猫」という一文を入力するだけで、プロのようなビジュアルを数秒で出力できるのが魅力です。その精度と柔軟性の高さから、広告・マンガ・動画制作・ファッションデザインなど幅広い分野で活用が広がっています。

また、MidjourneyやDALL·Eと異なり、自分好みにモデルを変更できる自由度の高さも人気の理由です。この記事では、Stable Diffusionの基本から応用、最新情報までを徹底的にガイドします。

2. 【基本編】Stable Diffusionの始め方と必要な環境

Stable Diffusionは高度なAIですが、意外にも導入はシンプルです。使い方は大きく分けて2通りあります。

1.ローカル環境で動かす

2.Google Colabで動かす

以下は、それぞれのインストールのしかたです。

● ローカル環境で動かす(PCで自由自在にカスタマイズ)

代表的な方法は「AUTOMATIC1111 Web UI」を使うやり方。

GitHubからコードを取得し、Python環境を整えれば、自分のPCでモデルを自在に操れます。

GPUを搭載したWindowsやMac(Mシリーズ)なら、快適に動作可能です。

現在では、GitHubからコードを取得したりしなくても、StabilityMatrixというアプリを使うことで、Stable Diffusionをインストールすることができるようになりました!

必要スペックの目安:

Windowsの場合:

- CPU:6コア以上

- メモリ(RAM):最低16GB 推奨32GB以上

- GPUメモリ(VRAM): 最低8GB 推奨16GB以上 ※Macの場合は最低M1チップ以上

- ストレージ(SSD):512GB以上

- OS:Windows

GPUメモリは16GB以上を推奨しています。Stable Diffusionは次々にバージョンが更新されていますが、SDXLモデルなど高画質化が進みGPUメモリの消費量が増える傾向になっています。そのため、PCを買う場合は後の増設することが難しいので、余裕を持ったGPU選択を推奨します。

Macの場合

- MacBook Pro

- CPU 8コア

- メモリ(RAM) 16GB

- チップ M1 Pro

※PCにM1チップもしくはGPUが搭載されていない場合は、Stable Diffusion Web UIを動かすことができません。

StabilityMatrixでのインストール方法

1.StabilityMatrixのGitHubに移動します。

2.GitHubのページが開いたら、下にスクロールしていくと、Assetsという項目があるので、その中の「StabilityMatrix-win-x64.zip」をクリックしてダウンロードします。

※今回はWindowsで解説するため、「StabilityMatrix-win-x64.zip」をダウンロードしています。

ダウンロードするファイルはご自身の環境に合わせて選んでください。

3.ダウンロードしたファイルを解凍します。

4.「StabilityMatrix.exe」をダブルクリックします。

※Windowsの警告画面が出た場合は、詳細情報を開いて実行を押します。

5.規約を読み同意にチェックを入れて、続けるを押します。

6.データフォルダにインストールフォルダパスを指定し、続けるを押します。

※Dドライブなどでもインストールできます。

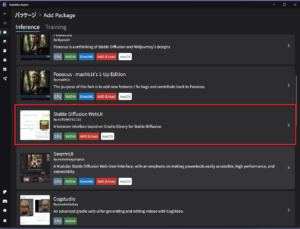

7.インストールしたいアプリを選択します。

※今回はStable Diffusion WebUIを選択。この時に、入れたいモデルがあれば選択すればインストールされます。

もしも、StabilityMatrixでのインストールがうまくいかなかった場合、以前のように、Python環境を構築して、Stable Diffusionを起動すると、うまくいく場合があります。

Windowsでインストールする場合の手順は

1.Pythonのインストール

2.Gitのインストール

3.Stable Diffusion WebUIのインストール

の3項目になります。

Pythonのインストール

1.自身のパソコンのシステムの種類が32bitか64bitかを確認する

1)キーボードのWindowsマークとXを同時押しし、メニューからシステムをクリックします。

2)システムの仕様のシステムの種類の欄を見て、32bitか64bitかを確認します。

※忘れても大丈夫なようにメモしておきましょう。

2.Pythonをインストールします。

1)Python公式ページに移動します。

※Python 3.10.6をダウンロードするので、そのページに移動してください(URLから直接飛べます)

2)Filesの中から、メモしておいた自身のパソコンのシステムの種類に合わせた、Windows installerをダウンロードします。

3)ダウンロードしたインストーラーを開きます。

4)Add Python 3.10 to Passにチェックを入れてInstall Nowをクリックします。

5)Setap was successfulが表示されたら、インストールが完了です。

Gitのインストール

1)Gitの公式ページから最新版のGitをダウンロードします。

※こちらも自身のパソコンのシステムの種類に合わせたインストーラーをダウンロードしてください。

2)ダウンロードしたインストーラーを起動します。

3)各ステップのNextボタンをクリックしていき、最後のステップでinstallボタンをクリックします。

※Nextボタンを押している間は、設定変更などはせず、デフォルト値のままで設定してください。

4)インストール完了の表示が出ればインストールは完了です。

Stable Diffusion WebUIのインストール

1)Stable Diffusion WebUIのデータを格納する任意のフォルダを開きます。

2)開いたフォルダ内で、右クリックして、Open Git Bash hereをクリックしてターミナルを開きます。

3)開いたターミナルに下記のコマンドを入力し、Enterを押します。

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

4)ダウンロードが始まるので、完了まで待ちます。

5)ダウンロードが完了すると、フォルダ内にstable-diffusion-webuiのフォルダが作成されているのを確認します。

6)stable-diffusion-webuiのフォルダ内の、下の方にweb-user.batというファイルがあるので、これをダブルクリックして、インストールを開始します。

7)インストールが完了すると、ターミナルにRunning on local URL: http://127.0.0.1:7860が表示され、Stable Diffusion WebUIが自動的に起動します。

Macでのインストールの手順は

1.Homeberwのインストール

2.Stable Diffusion WebUIのリポジトリのcloneを作成

3.webui-macros-envに”–no-half”を追加

4.Stable Diffusion WebUIのインストール

Homeberwのインストール

1)Finderを開き、アプリケーション>ユーティリティ>ターミナルを開きます。

2)ターミナルに以下のコマンドをコピペして、Enrerを押し、Homeberwをインストールします

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"3)インストール完了後ターミナルで以下のコマンドを実行します。

export PATH="$PATH:/opt/homebrew/bin/"4)インストール完了およびPATHが通っているかを確認します。

brew --versionStable Diffusion WebUIのインストール

1)ターミナルで以下のコマンドを入力し、必要なライブラリをインストールします

brew install cmake protobuf rust python@3.10 git wget2)Stable Diffusion WebUIのリポジトリをローカルPCにcloneします。

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui3)ターミナルで以下のコマンドを実行し、webui-macos-env.shファイルを編集します。

ファイルを開いたら、export COMMANDLINE_ARGS=~の末尾に “–no-half”を追加してください。

ファイル編集後は、[Ctrl] + [O]キーを押し、[Enter]キーを押します。

その後、[Ctrl] + [X]キーでファイル編集から抜けます。

編集前:

export COMMANDLINE_ARGS="--skip-torch-cuda-test --upcast-sampling

--no-half-vae --use-cpu interrogate"編集後:

export COMMANDLINE_ARGS="--skip-torch-cuda-test --upcast-sampling

--no-half-vae --use-cpu interrogate --no-half"※編集を咥えなかった場合、下記のエラーが出ることがあるため、対策として、編集しています。

エラー)untimeError: “upsample_nearest2d_channels_last” not implemented for ‘Half’

4)ターミナルで次のコマンドを実行し、Stable diffusion Web UIを起動します。

bash stable-diffusion-webui/webui.sh5)インストールが完了すると、ターミナルにRunning on local URL: http://127.0.0.1:7860が表示され、Stable Diffusion WebUIが自動的に起動します。

● ブラウザで手軽に使う(インストール不要)

初心者には「Google Colab」や「Hugging Face Spaces」などのクラウドサービスがおすすめです。アカウントを作成すれば、ブラウザからすぐに画像生成が可能。スマホでも操作できる簡便さが魅力です。

- 無料枠あり、ただし制限時間や待機列あり

- プログラミング不要で試せるUIも多数登場

Stable Diffusionは「動かし方を選べる自由さ」も特長です。まずはクラウドから試し、慣れてきたらローカル環境に挑戦してみるとよいでしょう。

● Google Colabで動かす(推奨環境ではないPCでもStable Diffusion WebUIが動かせる)

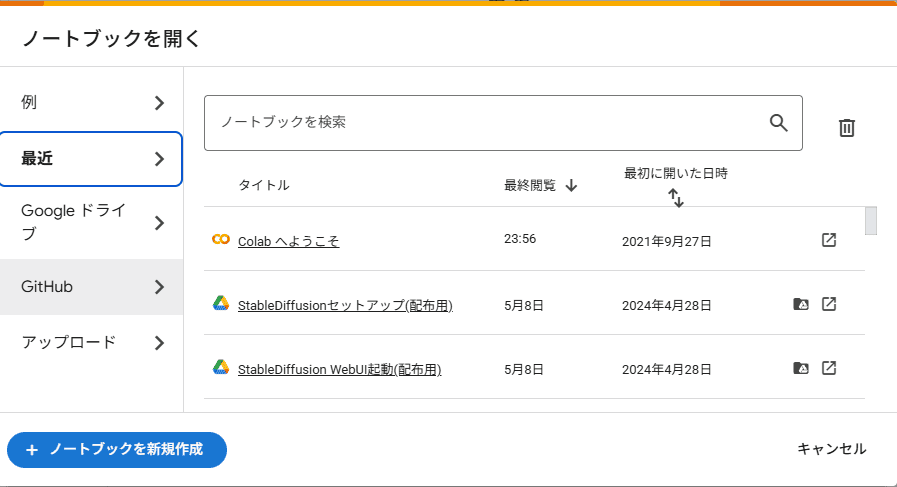

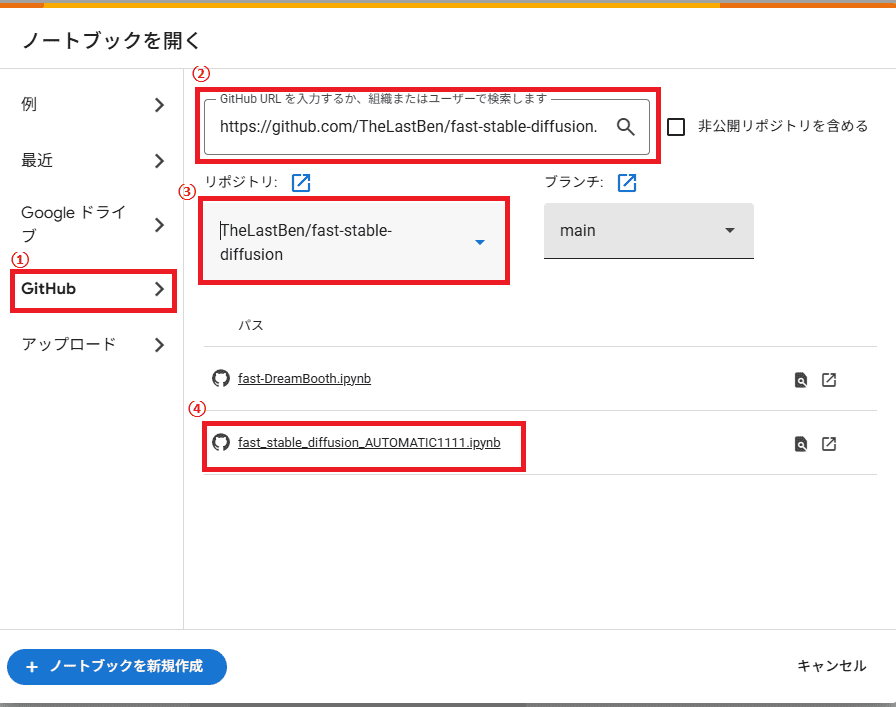

①Google Colab(https://colab.research.google.com/?hl=ja)を開いてファイルからノートブックを開くをクリック

②GitHubタブでhttps://github.com/TheLastBen/fast-stable-diffusion.gitを入力

以下の画像の手順通りに進めてください。

③GPUを有効化する

④ノートブックの上から実行ボタンを押していく。

⑤URLを開くと、立ち上げ完了

3. 【活用編】プロンプトの書き方と構造

Stable Diffusionの魅力は、”言葉”がそのまま”ビジュアル”になる魔法のような体験にあります。しかし、理想の絵を引き出すには、プロンプトの書き方にちょっとしたコツが必要です。

● ポジティブプロンプトとは?

Stable Diffusionで画像を生成する際に、「何を描いてほしいか」をAIに伝えるための指示文です。

より具体的に、かつ詳細に書くことで、狙ったビジュアルを得やすくなります。

やすくなります。

ポジティブプロンプトは以下のような要素で構成されます:

[主題], [外見・特徴], [背景・環境], [スタイル・アート表現], [ライティング・色], [技術的クオリティ]

各要素の例

- 主題:a girl, a dragon, a futuristic city

- 外見・特徴:wearing a kimono, mechanical wings, long silver hair

- 背景・環境:in a bamboo forest, on Mars, surrounded by fireflies

- スタイル・アート表現:anime style, oil painting, cyberpunk, ukiyo-e

- ライティング・色:soft lighting, neon lights, vibrant colors

- 技術的クオリティ:4K, ultra-detailed, photorealistic

書き方のポイント

主題を先に書く

→ a white cat sitting on a windowsill

形容詞を重ねて具体化する

→ fluffy, sleepy, glowing eyes

スタイルや構図を明記する

→ anime style, cinematic lighting, wide-angle shot

クオリティ指定で仕上げを強化

→ 8K, highly detailed, sharp focus

実例

a beautiful cyberpunk city at night, neon lights, reflective wet streets, flying cars, in the style of Blade Runner, ultra-detailed, 4K, cinematic lighting

→ブレードランナー風の美しくも退廃的な夜の都市を、ネオンと濡れた道路、飛行車で未来感を出しつつ、映画のような光で超高精細

a majestic white wolf howling on a snowy cliff, glowing eyes, full moon behind, anime style, dramatic lighting, high resolution

→雪の崖で遠吠えする白いオオカミを、満月と輝く目で神秘的に、アニメ風かつドラマチックな光で高精細に

● よく使われる定番キーワード集

| 分類 | キーワード例 |

|---|---|

| 解像度 | 4K, 8K, ultra-detailed |

| 光と演出 | cinematic lighting, volumetric light |

| スタイル | anime style, watercolor, gothic, vaporwave |

| 被写界深度 | shallow depth of field, bokeh |

| 質感・描写力 | hyper-realistic, photorealistic |

● ネガティブプロンプトとは?

Stable Diffusionで画像生成する際に、

「含めたくない要素」「避けたい失敗」を明示的に排除するための指示文です。

これを指定することで、品質の安定化・不要な欠損の回避など、生成画像の精度と完成度が向上します。

ネガティブプロンプトの目的

- 不自然な描写を避ける

- 画質劣化を防ぐ

- 不要なもの(透かし、テキスト、奇形など)を排除する

- 人間の手や顔、構造が崩れるのを防ぐ

基本構文

(worst quality, low resolution, blurry, deformed hands, extra limbs, disfigured, watermark, text, bad anatomy)

Stable Diffusionなどの画像生成AIでよく使われる「出てほしくない失敗やノイズ」をまとめて排除するための定番セットです。

それぞれのキーワードの意味

| キーワード | 意味・役割 |

| worst quality | 最も低品質な描写を除外 “とにかく酷い出力”を避けるための強力なフィルター モデルが不安定になったときの保険にもなる |

| low resolution | 解像度が低い・ぼやけた画像を防ぐ ノイズっぽいテクスチャや背景崩壊を回避 |

| blurry | ピントが合っていない・全体がぼやけている画像を排除 とくに「写真風」や「リアル系」では重要 |

| deformed hands | 手の形が崩れた描写を避ける AIは「指」を苦手とし、6本指・ねじれなどが起こりやすいため定番 |

| extra limbs | 手や足が2本以上余計に描かれる誤爆を避ける ハグや複数人が絡むシーンでとくに出やすい |

| disfigured | 顔や体のパーツが歪む・崩れるような描写を回避 顔の非対称、鼻・目の位置異常なども含む |

watermark | 著作権ロゴや透かしマークの混入を防ぐ 著作物由来の学習素材が原因で出現することがある |

| text | 不要な文字情報を排除 看板・背景・服に意味不明な英数字が勝手に生成されるのを防止 |

| bad anatomy | 人体構造が不自然な描写を防ぐ 関節の向きがおかしい、腕の長さが違う、胴体が曲がっている、など |

つまり、以下のようなAI画像のよくある問題点を一網打尽にするセットとなります:

不要な情報(文字、透かし)

品質が悪い(ぼやけ、解像度低下、ノイズ)

人体の破綻(指、手足、顔、骨格)

よく使われるネガティブプロンプト例と意味

| キーワード | 意味・役割 |

low quality | 全体の画質が悪くなるのを防ぐ |

blurry | ぼやけた、ピントの合っていない画像を防ぐ |

extra limbs | 手や足が多く描かれる失敗を防ぐ |

deformed hands | 手の形が崩れる、指が不自然になるのを防ぐ |

bad anatomy | 骨格や姿勢が不自然な描写を防ぐ |

text / watermark | ロゴ・透かし・文字が入るのを防ぐ |

disfigured | 顔や体のバランスが壊れる描写を避ける |

mutated | 不自然な形状変異(奇形)を防ぐ |

ugly | 美的に見劣りする出力を避けたいとき |

jpeg artifacts | 画質圧縮によるノイズの発生を防ぐ |

● 実用プロンプト例(日本語訳付き)

- ファンタジー風の騎士 a fantasy knight in shining armor, dramatic lighting, intricate detail, concept art style

→「輝く鎧をまとったファンタジー風の騎士、ドラマチックな光、緻密なディテール、コンセプトアート風」 - 浮世絵風の猫 a cat in ukiyo-e style, bold lines, traditional Japanese colors, Edo period

→「浮世絵風の猫、太い線、日本の伝統色、江戸時代風」

プロンプトは言葉の筆。描きたい世界を想像し、重ねて、洗練していく。それがStable Diffusionを操る鍵です。

・プロンプトで使われる主な記号の一覧

| 構文 | 意味 |

| (word) | 指定したキーワードを1.1倍にする |

| ((word)) | 指定したキーワードを1.21倍にする(1.1*1.1) |

| [word] | 指定したキーワードを0.9倍にする(1/1.1) |

| (word:1.5) | 指定したキーワードを1.5倍にする |

| (word:0.25) | 指定したキーワードを0.25倍にする ※[word:0.25]とはしないので注意が必要 |

| \(word\) ※バックスラッシュ | エスケープ ()や[]などの特殊文字を文字列として扱う |

| BREAK | チャンクを区切る |

| <lora: LoRA名:数値> | 指定したLoRAを指定する。数値は0~1で指定可能(0%~100%の意味) |

デフォルトのキーワードの強度は1です。

これに対して強調する場合は1以上、控えめにしたい場合は、1以下に設定します。

(word)の()は何重にもできますが、あまり多い場合は、(word:1.5)のような記述を利用する方がわかりやすいです。

()が重なるたびに、1.1倍になります。

4. 【応用編】モデル・LoRA・VAEとは?導入と切替方法

Stable Diffusionの本当の面白さは、自分好みに「育てていける」ことにあります。既存のモデルを入れ替えたり、LoRAで微調整を加えることで、画像のタッチや表現力が一気に変わります。

● モデル(checkpoint)とは?

Stable Diffusionの**モデル(checkpoint)は、画像を生成するための「学習済み脳みそ」**です。

どんな絵柄で、どんな雰囲気の画像を出すかは、このモデルによって大きく決まります。

初期のStable Diffusion 1.5や、高精細なSDXL、アニメ向けのAnything v5など、用途別に豊富な選択肢があります。

- 例:Realistic Vision(写真風)、MeinaMix(アニメ風)、DreamShaper(幻想系)

● LoRAとは?

LoRA(Low-Rank Adaptation)は、モデルの一部だけを上書きして特定のスタイルやキャラに最適化できる軽量ファイルです。

- 例:特定のイラストレーター風、VTuber風、ファッションスタイルなど

- 導入も簡単:

/models/Loraフォルダに入れるだけ、UIからチェックを入れるだけで使えます。

● VAEとは?

VAE(Variational AutoEncoder)は色味やコントラストに関わる補助的なファイルです。特に暗所や肌色が崩れる問題を軽減してくれます。

- 推奨:

vae-ft-mse-840000-ema-pruned.ckptなどを導入すると安定

● モデル導入手順(AUTOMATIC1111の場合)

- HuggingFaceやCivitaiから

.safetensorsファイルをダウンロード /models/Stable-diffusionに保存- WebUIからプルダウンで選択するだけ!

● モデルの切替で世界観が変わる

同じプロンプトでも、モデルが違えば出力される絵は別物になります。たとえば…

Deliberate→ 写実的でアート系RevAnimated→ デフォルメ感の強いアニメ風ChilloutMix→ 日本人女性に特化した自然な写真調

モデルの入れ替えは、世界を変える魔法のスイッチ。目的に応じて切り替えて、理想の一枚を手に入れましょう。

5. 【最新動向】2025年のStable Diffusionと生成AIの未来

Stable Diffusionは2025年に入り、さらに新たな進化を遂げています。生成精度、表現力、使いやすさ、そして商用利用の観点でも大きな変化が起きています。

● SDXL・SD3の登場で「次元」が変わった

Stable Diffusion XL(SDXL)は、従来の1.5系とは異なるアーキテクチャで、テキスト理解力と写実性が飛躍的に向上しました。さらに一部の開発者が公開している「SD3(仮称)」では、背景と人物の分離、手の描写、光と影の表現がより人間的になっています。

- 特徴:

- より自然な文章プロンプトに対応

- LoRA互換の拡張性も向上

- 「キャラ崩壊」が起きにくくなった

● 商用利用・著作権問題も整理されつつある

2023〜2024年にかけて話題となった「著作権」「AI学習の適法性」についても、各国でのガイドラインが整備され始めました。Stable Diffusionは基本的に商用利用OKですが、以下に注意が必要です。

- モデルやLoRAが「商用可」かどうかを確認(Civitaiに記載あり)

- 顔の類似・有名人使用などは要配慮(Deepfake規制等)

● 他AIとの共存時代へ

MidjourneyやDALL·E、そして音楽生成AIのSunoやUdioとの連携も活発化。1枚のビジュアルだけでなく、動画、音楽、ナレーションまでをAIで完結できる時代が見えてきました。

Stable Diffusionは、単なる画像生成ツールではなく、「創造のハブ」になろうとしています。

6. 【実例紹介】生成画像ギャラリーと成功プロンプト集

言葉が絵になる。それがStable Diffusionの醍醐味ですが、成功するプロンプトには「コツ」があります。ここでは実際に生成された画像とともに、そのプロンプトの構成を解説します。

● 実例1:幻想的な夜の街並み(サイバーパンク風)

- プロンプト cyberpunk city at night, glowing neon signs, rainy street, reflections, ultra-detailed, 8K, cinematic lighting

- 解説

「どんな場所か(cyberpunk city)」「時間帯(at night)」「光の演出(glowing neon, reflections)」というように、構図・光・解像度の順に並べるのがポイント。

● 実例2:浮世絵風の狐

- プロンプト a fox in ukiyo-e style, bold brush strokes, traditional Japanese colors, Edo period, flat composition

- 解説

画風(ukiyo-e)、筆致(bold brush strokes)、色彩(traditional colors)、構図(flat)を明示。日本風イラストの再現率を高める手法。

● 実例3:中世ファンタジーの女剣士

- プロンプト a female knight in medieval fantasy armor, standing in a windy battlefield, concept art, dynamic pose, intricate details

- 解説

ポーズ・服装・背景・アングルの指定に加え、「concept art」や「dynamic」でプロ感を演出。

● 成功率を上げるためのテクニック

- 具体性:「かわいい」より「ふわふわした白猫のぬいぐるみ風」

- スタイル名を活用:watercolor, 3D render, studio photo, sketch etc.

- ネガティブプロンプトで「崩れ」を抑える:extra fingers, deformed hands

生成AIは偶然の美しさも魅力ですが、「狙って当てる」ことも可能です。これらの例をテンプレに、自分だけの世界を描いてみてください。

【まとめ】最短でスキルを上げるStable Diffusionロードマップ

Stable Diffusionは、学べば学ぶほど面白くなるツールです。でも、はじめの一歩で迷子になる人も多い。ここでは、最短で“描ける人”になるためのロードマップを紹介します。

● ステップ1:とにかく動かしてみる

- WebUI(AUTOMATIC1111)またはGoogle Colabで起動

- 好きなキーワードを英語で打ち込んで画像を生成

- 「思ったのと違う」も大切な気づき

● ステップ2:プロンプトと構文に慣れる

- 他の人のプロンプト例を真似してみる(Civitai, Reddit, Discordなど)

- ネガティブプロンプトを意識的に入れてみる

- 一文ずつ調整して、結果の変化を比べる習慣をつける

● ステップ3:モデルとLoRAで表現力を広げる

- 自分の好みの世界観に合ったモデルを選定

- LoRAで好きな画風・キャラを“召喚”

- 複数のLoRAを掛け合わせてオリジナリティを出す

● ステップ4:作品を発表する

- SNS(X / Instagram)で投稿

- コンテストやAIアートの展示に応募

- 「タグ設計」や「構図の工夫」で見る人の心を動かす

● おすすめリソース

- 画像プロンプト集:Civitai / PromptHero

- チュートリアル動画:YouTube(例:あきらのAIラボ)

- コミュニティ:Discord「AI絵師の集い」など

- 自分用メモ帳:Notionでプロンプト記録、成功作ギャラリーに